С помощью применения нейронных сетей в различных областях, таких как компьютерное зрение, обработка естественного языка и речь, стала возможной автоматизация многих задач. Однако, с ростом размеров и сложности моделей, требования к их эффективности и производительности также увеличиваются.

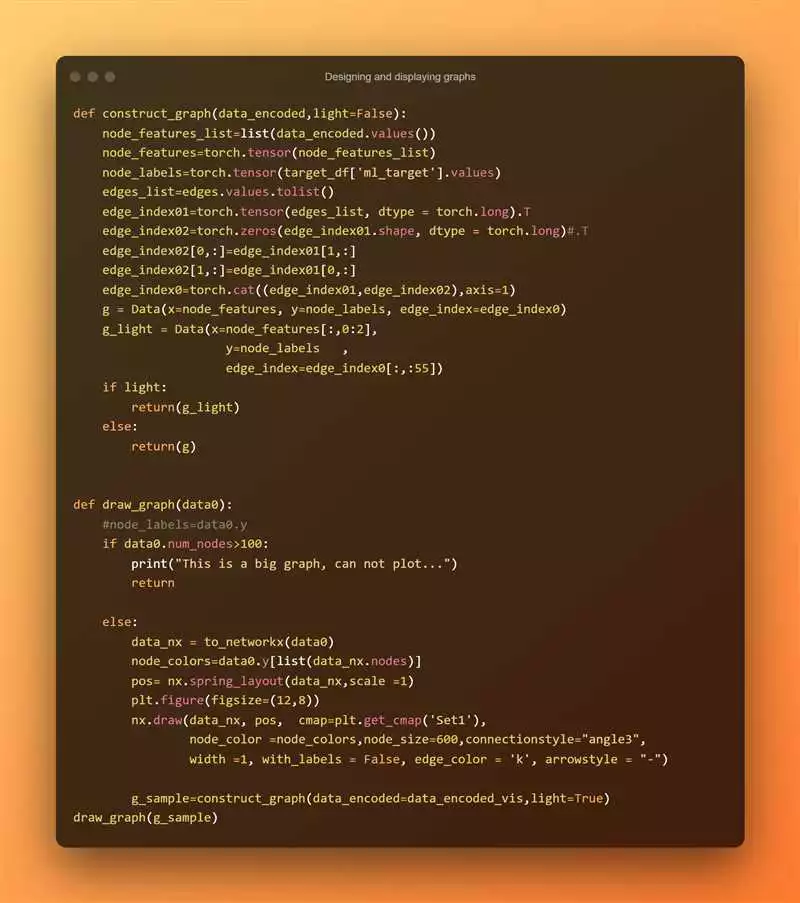

PyTorch является одним из наиболее популярных фреймворков для разработки нейронных сетей. Он предоставляет удобные средства для создания, обучения и оптимизации моделей. Однако, чтобы добиться оптимальной производительности, необходимо учитывать различные аспекты проектирования и настройки моделей.

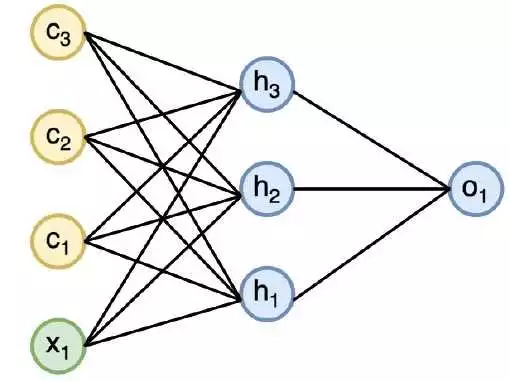

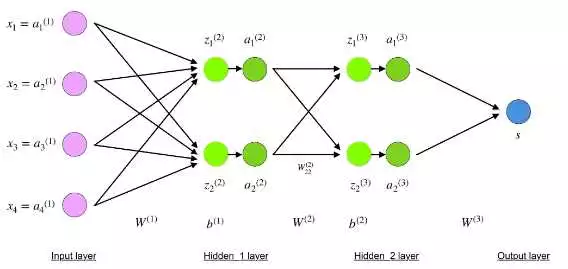

Одним из ключевых аспектов является выбор подходящей архитектуры сети. Различные типы сетей имеют свои преимущества и недостатки, поэтому важно выбирать ту, которая наилучшим образом соответствует поставленной задаче. Также стоит обратить внимание на оптимизацию процесса обучения, используя методы, такие как стохастический градиентный спуск и адаптивный шаг обучения.

Дополнительно, для улучшения производительности моделей можно применять различные техники, такие как регуляризация, усечение модели, обучение на большем объеме данных и использование предобученных моделей. При правильном применении этих методов можно достичь существенного увеличения производительности нейронных сетей.

Оптимизация и повышение производительности нейронных сетей с помощью PyTorch [PyTorch pytorch Фреймворки и библиотеки frameworks-and-libraries]

PyTorch — это фреймворк для глубокого обучения, который позволяет создавать и оптимизировать нейронные сети. С помощью PyTorch можно решать самые разнообразные задачи, начиная с классификации и заканчивая генерацией изображений.

Оптимизация и повышение производительности нейронных сетей являются ключевыми аспектами в сфере глубокого обучения. На практике часто возникают ситуации, когда нейронная сеть работает медленно или потребляет большое количество ресурсов. Это может ограничивать возможности использования нейронных сетей в различных приложениях.

С помощью PyTorch можно применять различные техники оптимизации для улучшения эффективности нейронных сетей. Одной из таких техник является оптимизация процесса обучения сети. При обучении нейронной сети можно использовать различные методы и алгоритмы оптимизации, такие как стохастический градиентный спуск или адаптивные методы оптимизации, для достижения более быстрой и точной сходимости.

Также, PyTorch позволяет улучшить эффективность работы нейронных сетей путем использования различных методов оптимизации памяти. Например, можно использовать технику batch normalization, которая позволяет нормализовать входные данные перед их передачей в нейронную сеть. Это позволяет сети работать более стабильно и эффективно.

Другим методом оптимизации является использование параллельных вычислений с помощью PyTorch. Параллельные вычисления позволяют распараллеливать процесс обучения или применения нейронной сети, что увеличивает скорость выполнения и эффективность работы сети.

Важным аспектом оптимизации и повышения производительности нейронных сетей является подбор оптимальной архитектуры сети. PyTorch предоставляет возможность создания сложных моделей с использованием различных типов слоев и блоков. Подбор подходящей архитектуры сети позволяет достичь оптимальных результатов при минимальных затратах ресурсов.

В заключение, PyTorch предоставляет широкий набор инструментов и возможностей для оптимизации и повышения производительности нейронных сетей. Применение этих методов может существенно улучшить работу сетей, обеспечивая более быструю и точную обработку данных.

Раздел 1: Улучшение работы нейронных сетей с помощью PyTorch

Одной из ключевых задач при работе с нейронными сетями является их оптимизация и повышение производительности. В этом разделе мы рассмотрим, как можно улучшить работу нейронных сетей с применением фреймворка PyTorch.

1. Использование оптимизаторов

PyTorch предоставляет различные оптимизаторы, которые помогают улучшить эффективность работы нейронных сетей. Одним из наиболее популярных оптимизаторов является Adam. Он сочетает в себе преимущества методов градиентного спуска и стохастического градиентного спуска, позволяя достичь хороших результатов при минимальных затратах по времени и ресурсам.

2. Увеличение эффективности обучения

Для увеличения эффективности обучения нейронных сетей можно применять такие методы, как регуляризация и упреждающая аугментация данных. Регуляризация позволяет ограничить сложность модели и предотвратить переобучение, а упреждающая аугментация данных позволяет увеличить разнообразие обучающей выборки, улучшая обобщающую способность модели.

3. Параллельное обучение

PyTorch предоставляет возможность использовать несколько графических процессоров для ускорения обучения нейронных сетей. Это достигается с помощью модуля torch.nn.DataParallel, который автоматически разделяет данные на разные процессы и обучает модель на каждом из них параллельно. Такой подход позволяет значительно сократить время обучения и повысить производительность.

4. Оптимизация производительности

Следующий шаг в улучшении работы нейронных сетей с применением PyTorch — это оптимизация производительности. Для достижения наивысшей эффективности можно использовать следующие подходы:

- Использование GPU — PyTorch позволяет выполнять вычисления на графическом процессоре, что позволяет значительно ускорить процесс обучения и инференса модели.

- Оптимизация загрузки данных — можно использовать различные техники для оптимизации загрузки данных, такие как предварительное чтение данных в память или использование специальных инструментов, например, PyTorch DataLoader.

- Профилирование и оптимизация кода — можно использовать инструменты профилирования, такие как PyTorch Profiler, для выявления критических участков кода и оптимизации их работы. Также полезно проводить эксперименты с различными гиперпараметрами модели и алгоритмом оптимизации, чтобы найти оптимальные значения.

5. Summing up

В данном разделе мы рассмотрели различные методы и подходы, которые помогают улучшить работу нейронных сетей с помощью фреймворка PyTorch. Оптимизация и повышение производительности являются важными задачами при работе с нейронными сетями, и правильное использование PyTorch позволяет существенно улучшить результаты и эффективность работы моделей.

Использование оптимизаторов в PyTorch

Для оптимального применения нейронных сетей и повышения их производительности и эффективности возможно использование различных оптимизаторов в библиотеке PyTorch. Оптимизация является ключевым этапом в обучении нейронных сетей, поскольку она позволяет найти оптимальные значения весов модели.

PyTorch предоставляет широкий выбор оптимизаторов, которые могут быть использованы в различных задачах машинного обучения. Некоторые из самых популярных оптимизаторов в PyTorch включают в себя:

- SGD (Stochastic Gradient Descent): классический оптимизатор, который обновляет параметры модели, используя градиенты случайно выбранных подмножеств данных;

- Adam (Adaptive Moment Estimation): оптимизатор, комбинирующий идеи из метода обучения со стохастическим градиентным спуском и адаптивного градиентного спуска;

- Adagrad (Adaptive Gradient): оптимизатор, который адаптивно масштабирует обучение по каждому параметру на основе его истории градиентных обновлений;

- RMSprop (Root Mean Square Propagation): оптимизатор, который использует экспоненциально взвешенное среднее для обновления шага обучения;

- AdamW: оптимизатор Adam с добавленным весовым затуханием (weight decay), что помогает предотвратить переусложнение модели.

При выборе оптимизатора необходимо учитывать конкретную задачу и структуру нейронной сети. Разные оптимизаторы могут обеспечить различные скорости сходимости и качество оптимизации, поэтому иногда может потребоваться экспериментирование с разными оптимизаторами для достижения наилучших результатов.

Важной частью использования оптимизаторов в PyTorch является правильная настройка параметров оптимизатора, таких как скорость обучения (learning rate), момент (momentum), весовое затухание (weight decay) и другие. Эти параметры могут сильно влиять на процесс обучения и качество модели, поэтому необходимо проводить эксперименты для нахождения оптимальных значений.

| Оптимизатор | Описание |

|---|---|

| SGD | Классический оптимизатор, использующий стохастический градиентный спуск |

| Adam | Оптимизатор, комбинирующий идеи из SGD и адаптивного градиентного спуска |

| Adagrad | Оптимизатор, адаптивно масштабирующий обучение для каждого параметра |

| RMSprop | Оптимизатор, использующий экспоненциально взвешенное среднее для обновления шага обучения |

| AdamW | Оптимизатор Adam с весовым затуханием (weight decay) |

В итоге использование оптимизаторов в PyTorch позволяет увеличить производительность и эффективность нейронных сетей, находить оптимальные значения весов модели и достигать лучших результатов в задачах машинного обучения.

Применение функции активации в PyTorch

Для увеличения производительности и оптимизации нейронных сетей с помощью PyTorch, одной из ключевых составляющих является выбор и применение правильной функции активации. Функция активации играет важную роль в улучшении эффективности обучения нейронных сетей и повышении качества предсказаний.

PyTorch предоставляет различные варианты функций активации, которые могут быть применены к нейронным сетям. Каждая из этих функций имеет свои преимущества и недостатки, и выбор правильной функции активации зависит от задачи и данных, с которыми вы работаете.

Одной из самых популярных функций активации в PyTorch является ReLU (Rectified Linear Unit). Она представляет собой простую нелинейную функцию, которая заменяет все отрицательные значения на ноль и оставляет положительные значения без изменений. Применение ReLU позволяет сетям лучше улавливать нелинейные зависимости в данных и ускоряет обучение.

Еще одним вариантом функции активации, которую можно использовать в PyTorch, является сигмоида. Сигмоида преобразует любое вещественное число в диапазоне от 0 до 1. Это особенно полезно для задач классификации, где требуется предсказать вероятности принадлежности к различным классам.

Также в PyTorch доступна функция активации Tanh, которая также ограничивает значения в диапазоне от -1 до 1. Она имеет схожее преобразование с сигмоидом, но находится в диапазоне [-1, 1]. Применение Tanh может быть полезно, когда нужно выявить более сложные зависимости в данных.

Помимо основных функций активации, PyTorch также предлагает другие функции, такие как Softmax, PReLU (Parametric ReLU), LeakyReLU и др. Каждая из этих функций имеет свои особенности и может быть применена в зависимости от задачи и требуемого поведения нейронной сети.

| Функция активации | Описание |

|---|---|

| ReLU | Простая нелинейная функция, обнуляющая все отрицательные значения |

| Sigmoid | Функция, преобразующая значения в диапазоне [0, 1] |

| Tanh | Функция, преобразующая значения в диапазоне [-1, 1] |

| Softmax | Функция для предсказания вероятностей классов в задаче многоклассовой классификации |

| PReLU | Модификация ReLU с весами, которые могут быть обучаемыми |

| LeakyReLU | Модификация ReLU, которая имеет небольшой наклон для отрицательных значений |

Выбор функции активации зависит от задачи и данных, поэтому рекомендуется провести эксперименты с различными функциями активации и выбрать наиболее подходящую для вашей нейронной сети.

Таким образом, применение правильной функции активации в PyTorch является важным шагом в оптимизации и повышении производительности нейронных сетей, а выбор функции активации зависит от поставленных задач и требуемых результатов.

Улучшение скорости обучения при применении PyTorch

Одной из ключевых задач в области нейронных сетей является улучшение производительности и скорости обучения. С использованием фреймворка PyTorch можно значительно ускорить процесс обучения и достичь более высоких результатов.

Для улучшения производительности и скорости обучения нейронных сетей с помощью PyTorch существует несколько подходов:

- Использование GPU для обучения и инференса. PyTorch позволяет легко перенести вычисления на графический процессор, что может значительно ускорить процесс обучения. Для этого необходимо установить и настроить соответствующий драйвер и использовать функции PyTorch для работы с GPU.

- Оптимизация алгоритмов обучения. PyTorch предоставляет широкий набор инструментов для оптимизации алгоритмов обучения, таких как различные оптимизаторы (например, Adam, SGD), функции активации, функции потерь и другие. Выбор эффективных алгоритмов обучения может значительно повысить производительность и скорость обучения.

- Использование распределенных вычислений. PyTorch имеет поддержку распределенных вычислений, что позволяет обучать нейронные сети на нескольких узлах с использованием нескольких GPU. Это позволяет увеличить скорость обучения и повысить производительность.

В дополнение к вышеперечисленным подходам, существует множество других методов и инструментов для улучшения скорости обучения при применении PyTorch. Их выбор и оптимизация зависит от конкретной задачи и целей исследования или разработки нейронных сетей.

| Метод/Инструмент | Описание |

|---|---|

| Другие оптимизаторы | Дополнительные оптимизаторы, такие как RMSprop или Adagrad, могут быть эффективными в определенных ситуациях и улучшить скорость обучения. |

| Уменьшение размерности входных данных | Уменьшение размерности входных данных (например, с помощью PCA или автоэнкодеров) может ускорить обучение и улучшить производительность нейронных сетей. |

| Увеличение размера батча | Использование больших размеров батчей может ускорить обучение, так как GPU может параллельно обрабатывать больше данных. |

Важно отметить, что выбор и применение методов и инструментов для улучшения скорости обучения в PyTorch зависит от конкретной задачи и требований проекта. Необходимо проводить эксперименты и тестирование для выбора оптимальных подходов и достижения максимальной производительности нейронных сетей.