Современные технологии позволяют собирать и хранить огромные объемы данных, однако их обработка может быть крайне сложной задачей. Для работы с крупными объемами данных на языке программирования Python существует множество эффективных методик и передовых инструментов.

Ведущие методы работы с большими объемами данных включают массовую обработку и анализ данных, использование оптимальных алгоритмов и техник программирования, а также оптимизацию работы с массивами и великими объемами информации. Продуктивные решения на Python позволяют легко и эффективно обрабатывать, анализировать и изучать большой объем данных.

В данной статье будут рассмотрены наилучшие подходы к работе с большими объемами данных, лучшие методы и приемы их обработки с использованием современных инструментов и средств. Будут представлены отборные и оптимальные методики работы с обширными объемами данных, а также лучшие программные средства и программирования на языке Python, которые позволяют значительно упростить и ускорить процесс обработки данных и их анализа.

Эффективные методы и лучшие инструменты

Работа с большими данными стала актуальной задачей в современном мире. Обширные объемы информации требуют массовой обработки и анализа для получения ценных данных. В этом контексте Python является одним из ведущих и наиболее продуктивных языков программирования.

Работа с большими объемами данных на Python возможна благодаря использованию современных техник и инструментов. Для эффективного исследования и обработки таких объемов информации необходимо использование оптимальных подходов и методик. Python предоставляет разнообразные средства и библиотеки для обработки и анализа данных.

Одним из лучших инструментов для работы с большим объемом данных на Python являются массивы NumPy. Они позволяют эффективно работать с крупными объемами информации, обеспечивая высокую производительность и эффективность при решении задач обработки данных.

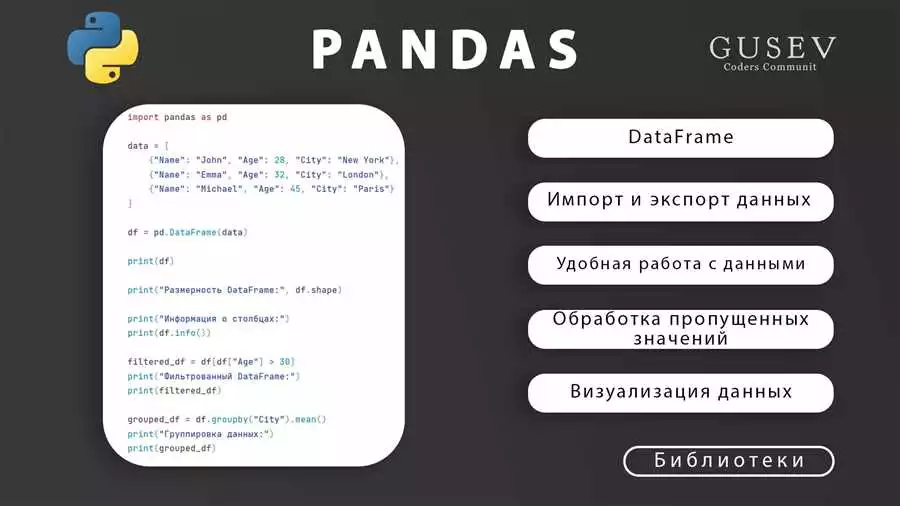

Для работы с большими данными на Python также используются высокопроизводительные библиотеки, такие как pandas. Они предоставляют мощные инструменты для анализа и обработки данных в таблицах. Такие инструменты позволяют легко справиться с огромными объемами данных, проводить исследование и анализ, а также выполнять различные операции.

При работе с большими объемами данных на Python также важно использовать оптимизационные методы и техники. Это позволяет добиться более эффективной обработки данных и повысить производительность программы. Алгоритмы оптимизации позволяют сократить время работы программы и снизить нагрузку на систему.

Другими важными методиками при работе с большими объемами данных на Python являются параллельные вычисления и распределенная обработка данных. Такие подходы позволяют распараллелить выполнение задач и ускорить работу с огромными объемами данных. Библиотеки, такие как Dask, позволяют кратно ускорить обработку данных и справиться с большими нагрузками.

Использование эффективных методов и инструментов для работы с большими объемами данных на Python является наилучшим решением. Подобные методы и приемы позволяют повысить эффективность обработки и анализа информации, сэкономить время и ресурсы.

В итоге, работа с большими объемами данных на Python является актуальной и востребованной задачей. Современные подходы, методы и инструменты позволяют эффективно выполнять обработку и анализ данных, достигая подходящих результатов в кратчайшие сроки.

Работа с большими объемами данных на Python:

Современные задачи программирования все чаще требуют работу с массовой объемной информацией. Для успешного решения таких задач необходимы передовые алгоритмы и эффективные методы обработки данных. В данной статье рассмотрим лучшие инструменты и возможности языка программирования Python для работы с большими объемами данных.

Методы обработки данных:

Для работы с огромными объемами данных необходимы специальные методики и техники обработки. Одним из наилучших подходов является использование методов оптимизации и отборные приемы работы с массивами данных. Также очень важно выбрать наиболее эффективные алгоритмы для обработки данных.

Лучшие инструменты и средства:

Python является одним из ведущих языков программирования, предлагающих широкий набор инструментов и средств для работы с большими объемами данных. Наиболее популярные инструменты включают:

- NumPy: библиотека для работы с многомерными массивами и перемножением матриц;

- Pandas: библиотека для удобной и эффективной работы с данными в виде таблиц;

- Dask: библиотека для параллельной обработки больших объемов данных;

- PySpark: библиотека для работы с распределенными данными и выполнения анализа на крупных объемах данных;

- Базы данных: использование специализированных баз данных для хранения и обработки больших объемов данных.

Оптимальные методы и подходы:

Для эффективной работы с большими объемами данных на Python рекомендуется использовать следующие оптимальные методы и подходы:

- Использование индексов для быстрого доступа к данным;

- Параллельная обработка данных для ускорения работы;

- Использование итераторов и генераторов для эффективной обработки больших объемов данных;

- Выделение и работы только с необходимыми колонками и строками данных;

- Агрегационные функции для сводной статистики по большим объемам данных.

Исследование и изучение данных:

Для эффективной работы с большими объемами данных необходимо проводить их исследование и изучение. С помощью Python можно использовать различные инструменты и библиотеки для анализа данных, визуализации и построения моделей. Наиболее популярные инструменты для работы с данными включают:

- Matplotlib: библиотека для визуализации данных;

- Seaborn: библиотека для создания статистических графиков;

- Scikit-learn: библиотека для машинного обучения и построения моделей;

- Jupyter Notebook: инструмент для интерактивного изучения и анализа данных.

Программирование на Python для работы с большими объемами данных:

Python предлагает широкие возможности для эффективной работы с большими объемами данных. Программирование на Python для работы с данными включает использование удобных и мощных инструментов, алгоритмов и методов обработки. Благодаря гибкому синтаксису и поддержке множества библиотек, Python является наилучшим языком программирования для работы с объемными и обширными данными.

В заключение, работа с большими объемами данных на Python требует использования продуктивных методов и эффективных инструментов. Современные техники обработки данных, ведущие библиотеки и софт для анализа данных позволяют решать сложные задачи и извлекать максимальную пользу из объемных данных.

Эффективные методы

Работа с большими объемами данных — ведущая задача в современном программировании. Великие объемы данных требуют от разработчиков использования оптимальных и эффективных методов и инструментов для их обработки и анализа. В этом разделе мы рассмотрим лучшие подходы и техники, которые помогут вам справиться с обширными массивами данных.

Использование Python для работы с большими объемами данных

Python — язык программирования, который широко используется для работы с данными. Его простота и гибкость делают его отличным выбором для работы с большими объемами данных. В Python существует большое количество библиотек и инструментов, специально разработанных для обработки и анализа данных.

Оптимальные методы обработки и анализа данных

Для работы с большими объемами данных необходимы оптимальные методы и алгоритмы. Использование современных алгоритмических приемов позволяет эффективно обрабатывать и анализировать огромные объемы данных.

Продуктивные методы программирования на Python

При работе с большими объемами данных на языке Python рекомендуется использовать продуктивные методы программирования. Выбор правильных структур данных, оптимизация кода и использование средств многопоточности и параллельного программирования помогут значительно ускорить работу с данными и снизить время обработки.

Использование передовых инструментов и методик

Для работы с большими объемами данных рекомендуется использовать передовые инструменты и методики. Например, использование баз данных, распределенных вычислений, кеширования и других средств может значительно улучшить производительность обработки данных.

Изучение и исследование эффективных методов

Изучение и исследование эффективных методов работы с большими объемами данных является важной задачей при работе с данными. Регулярное ознакомление с новейшими разработками и методиками позволит вам быть в курсе последних тенденций в области обработки данных.

Лучшие инструменты для работы с большими объемами данных

Для работы с большими объемами данных существует множество передовых инструментов. Некоторые из них специализированы на обработке больших объемов данных, другие предоставляют широкий набор функций для работы с данными. Проанализируйте ваши требования и выберите лучшие инструменты для вашей задачи.

Оптимизация работы с большими объемами данных

Оптимизация работы с большими объемами данных является важным фактором для достижения высокой производительности. Использование оптимальных подходов и инструментов позволяет сократить время обработки и анализа данных, совершенствовать работу алгоритмов и повышать эффективность вашего кода.

Массовая обработка данных на Python

Массовая обработка данных — одна из наиболее важных задач в работе с большими объемами данных. Благодаря мощности и гибкости языка Python, вы можете использовать его для решения самых разных задач по обработке и анализу огромных объемов данных.

Таблица: Подходы и методы для работы с большими объемами данных

| Метод | Описание |

|---|---|

| Использование оптимальных алгоритмов | Выбор наилучших алгоритмов для эффективной обработки данных |

| Оптимизация кода | Разработка эффективного и оптимизированного кода для работы с данными |

| Использование средств многопоточности и параллельного программирования | Распараллеливание работы с данными для повышения производительности |

| Использование передовых инструментов и методик | Применение передовых инструментов и методик для оптимизации работы с данными |

| Изучение и исследование новых методов | Постоянное изучение и исследование новых методов для работы с данными |

Использование генераторов

Использование генераторов является одной из эффективных техник работы с большими объемами данных в программировании на Python. Генераторы представляют собой мощные средства обработки и анализа крупных объемов данных, позволяющие оптимизировать работу с массовой информацией.

Основной принцип генераторов заключается в создании итераторов, которые генерируют значения по мере необходимости, вместо создания и хранения полного массива данных. Это позволяет экономить память и ускорять выполнение операций с большими объемами данных.

Генераторы используются для решения различных задач обработки данных и анализа больших объемов информации. Они являются одним из наилучших подходов к работе с обширными и огромными объемами данных в Python, обеспечивая эффективные и оптимальные решения.

Преимущества использования генераторов:

- Экономия памяти: генераторы позволяют обрабатывать большие объемы данных без загрузки и хранения всей информации в памяти компьютера.

- Продуктивность: генераторы позволяют проводить анализ и исследование больших объемов данных с использованием отборных и эффективных алгоритмов.

- Удобство: прозрачность работы генераторов позволяет легко использовать их в различных сферах и задачах обработки данных.

- Оптимизация: генераторы обеспечивают оптимальные методы работы с большими объемами данных, позволяющие повысить скорость выполнения программы.

При работе с большими объемами данных в Python рекомендуется использовать современные и передовые методики и инструменты. Благодаря генераторам программисты получают возможность эффективно обрабатывать и анализировать огромные массивы данных, оптимизируя время работы и ресурсы компьютера.

| Задача | Пример кода |

|---|---|

| Подсчет суммы элементов списка | sum_of_list = sum(num for num in my_list) |

| Фильтрация данных из файла | filtered_data = (line for line in file if line.startswith('A')) |

| Генерация последовательности чисел | numbers = (num for num in range(1, 1000000)) |

Использование генераторов является одним из наилучших подходов к работе с большими объемами данных в Python. Они позволяют эффективно обрабатывать, анализировать и исследовать огромные объемы информации, предоставляя программистам мощные и интуитивно понятные инструменты работы с данными.

Многопоточная обработка данных

Работа с большими объемами данных является актуальной задачей в современной информационной среде. Для обработки таких объемов данных необходимы эффективные методы и инструменты. Одним из подходов к оптимизации работы с большими объемами данных является многопоточная обработка.

Многопоточная обработка данных в языке программирования Python предоставляет возможность параллельной обработки крупных массивов данных. Это позволяет существенно повысить производительность и ускорить обработку данных.

Приемы и подходы к многопоточной обработке данных на Python включают в себя использование потоков (threads) и процессов (processes), а также применение различных техник и методик, таких как синхронизация, блокировки, разделение ресурсов и другие.

Для работы с большими объемами данных на Python существует множество передовых решений и современных инструментов. Некоторые из них позволяют эффективно работать с обширными массивами данных, другие предоставляют оптимальные методы обработки большого объема информации.

Одним из наилучших инструментов для работы с большими объемами данных на Python является библиотека Pandas. Она предоставляет мощные средства и функции для работы с массивами данных, включая возможность параллельной обработки и работу с огромными объемами информации.

Для эффективной обработки больших объемов данных на Python также используются средства многопоточности и параллельных вычислений, такие как библиотеки threading и multiprocessing. Они позволяют распараллеливать выполнение задач и ускорять обработку данных.

Методы программирования с использованием многопоточности в Python обычно основываются на алгоритмах и действиях, которые можно разделить на отдельные потоки или процессы. Они позволяют эффективно решать задачи обработки большого объема данных и обеспечивают высокую производительность при работе с массивами данных.

Изучение и использование многопоточной обработки данных на Python являются ведущими подходами в области работы с большими объемами информации. Программисты и исследователи активно применяют эти методы и техники для работы с большими объемами данных.

В заключение, многопоточная обработка данных на Python является одним из лучших и эффективных подходов к работе с большими объемами данных. Программирование с использованием многопоточности и параллельных вычислений позволяет оптимизировать обработку больших объемов информации и достичь наиболее продуктивных результатов.

Оптимизация работы с памятью

При работе с большими объемами данных на Python, эффективное использование памяти является одним из ключевых аспектов. Обработка крупных и огромных объемов данных требует массовой работы с памятью, поэтому использование лучших методов и инструментов является необходимым.

Перед изучением методик оптимизации работы с памятью, рекомендуется провести исследование и изучение современных подходов к обработке больших объемов данных на Python. Существует множество программ и библиотек, которые специализируются на работе с большими объемами данных и предоставляют продуктивные и эффективные решения.

Одним из ведущих языков программирования для работы с большими объемами данных является Python. Это связано с тем, что Python предоставляет обширные средства для работы с большими объемами данных. Среди них наилучший инструмент для работы с массивами — библиотека NumPy, которая позволяет эффективно обрабатывать большие объемы данных и выполнять сложные анализы.

Для оптимальной работы с большими объемами данных необходимо использовать эффективные алгоритмы и методы программирования. Некоторые из лучших методов и приемов оптимизации работы с памятью на Python включают:

- Использование генераторов и итераторов для уменьшения нагрузки на память. Генераторы позволяют генерировать данные по мере необходимости, минимизируя использование памяти.

- Использование in-place операций для изменения данных на месте, минимизируя создание копий и использование дополнительной памяти.

- Выполнение операций над данными пакетно с использованием библиотеки NumPy. Пакетная обработка массивов позволяет сократить количество операций и использование памяти.

- Оптимизация работы с памятью при чтении и записи больших файлов. Использование контекстных менеджеров и итераторов для поэлементной обработки данных из файла может значительно сократить использование памяти.

- Использование эффективных структур данных, например, хеш-таблиц и set-коллекций, для уменьшения размера хранимых данных и оптимизации операций поиска и сравнения.

Оптимизация работы с памятью при обработке больших объемов данных является важным фактором для эффективного выполнения задач. Применение указанных выше методик и инструментов позволяет значительно сократить использование памяти и повысить производительность программы на Python при работе с большими объемами данных.

Лучшие инструменты

В мире программирования и анализа работы с большими объемными данными существует множество отборных инструментов и методов. Подходы к работе с крупными массивами информации и обработкой большими объемами данных постоянно совершенствуются. Для изучения и работы с огромными объемами данных лучшее решение — использование эффективных и продуктивных инструментов и техник.

Ведущие инструменты

На сегодняшний день ведущие инструменты для работы с большими объемами данных на языке Python – это: Pandas, NumPy, Dask, PySpark, Hadoop, Apache Kafka, Apache Storm.

Pandas – это библиотека, позволяющая удобно и быстро проводить массовую обработку и анализ данных.

NumPy – библиотека, предоставляющая специализированные техники и средства для работы с массивами данных.

Dask – библиотека, обеспечивающая разделение данных на блоки и их последующую обработку параллельно.

PySpark – это библиотека для работы с данными в распределенной среде с использованием Apache Spark.

Hadoop – фреймворк, предназначенный для обработки и хранения больших объемов данных в распределенной среде.

Apache Kafka – система обмена сообщениями между компонентами, позволяющая обрабатывать данные в реальном времени.

Apache Storm – распределенная система для обработки данных в реальном времени.

Оптимальные методы и приемы

Для работы с большими объемами данных на Python есть ряд оптимальных методов и приемов:

- Использование алгоритмов с применением параллельных и распределенных вычислений.

- Оптимизация кода и использование векторизации операций.

- Работа с фрагментами данных при обработке, вместо загрузки полного объема данных в память.

- Использование индексов и хеширования для быстрого доступа к данным.

- Кэширование промежуточных результатов вычислений.

Исследование, обработка и анализ данных

Для успешного исследования, обработки и анализа больших объемов данных необходимо использование передовых методик и техник, среди которых:

- Визуализация данных с использованием библиотек, таких как Matplotlib и Seaborn.

- Применение статистических методов для анализа данных.

- Машинное обучение и использование алгоритмов машинного обучения.

- Обработка текстовой информации с использованием библиотек, например, NLTK.

- Использование графовых баз данных для работы с связанными данными.

Наличие оптимальных инструментов и методов в работе с большими объемами данных на языке Python позволяет значительно увеличить производительность анализа и обработки данных, ведь выбор наилучших решений играет важную роль в успешной работе с крупными объемами информации.

Библиотека Pandas

Библиотека Pandas — одно из наилучших средств программирования на языке Python для работы с массовой обработкой данных. Она предоставляет мощные и эффективные методы и техники для анализа и обработки больших объемов данных.

Библиотека Pandas предлагает передовые методы обработки данных, оптимальные алгоритмы и инструменты для работы с объемными массивами данных. С ее помощью можно эффективно проводить исследование и анализ данных, а также реализовывать продуктивные методики обработки.

Одним из ключевых преимуществ Pandas является его удобный и интуитивно понятный интерфейс. Благодаря этому, работа с большими объемами данных становится более простой и комфортной.

Пандас предоставляет широкий набор функций и методов для работы с данными, таких как фильтрация, сортировка, агрегация, изменение типов данных, мерджи и группировка. Он также позволяет легко читать и записывать данные из различных источников, таких как файлы CSV, Excel, базы данных, а также различные форматы данных в памяти.

Библиотека Pandas предлагает множество лучших подходов к обработке больших объемов данных. Ее функциональность включает в себя мощные инструменты для работы с временными рядами, а также возможность работы с многомерными данными.

Оптимизация работы с данными — одна из главных задач библиотеки Pandas. Она активно использует передовые техники и алгоритмы для оптимальной работы с большими объемами данных. Такие методы включают в себя эффективное использование памяти, параллельную обработку, векторизацию операций и другие приемы. Благодаря этому, использование Pandas позволяет достичь великолепных результатов при обработке данных.

Библиотека Pandas является одним из ведущих инструментов для работы с большими объемами данных в Python. Она предлагает массу возможностей и преимуществ, что делает ее идеальным решением для работы с огромными объемами данных. Благодаря этому, Pandas стал неотъемлемой частью современных методик исследования и анализа данных.

Использование Pandas в комбинации с другими библиотеками, такими как NumPy, Matplotlib и Scikit-learn, позволяет получить еще более мощные и эффективные инструменты для обработки и анализа данных.

Библиотека Pandas — это наилучшее средство для работы с объемными данными на языке программирования Python. Она предлагает лучшие подходы и методы обработки данных, эффективные приемы и современные методики, что делает ее неотъемлемой частью работы с большими объемами данных.

Apache Spark

Apache Spark — это ведущий инструмент для работы с большими объемами данных на языке программирования Python. Он предоставляет эффективные методы и оптимальные алгоритмы для обработки и анализа огромных объемов данных.

Spark обеспечивает высокую производительность при работе с крупными и объемными наборами данных. Он предлагает подходы и техники для работы с данными, которые позволяют эффективно выполнять обработку, отборные поисковые запросы и анализ массивов данных. С помощью Spark можно легко обрабатывать большие объемы данных, используя продуктивные и современные методы программирования.

Средства, предоставляемые Spark, позволяют решать задачи, связанные с массовой обработкой данных. Использование Spark позволяет осуществлять исследование и наилучший отбор данных, а также параллельно выполнять работу с большими объемами данных. С помощью Spark можно эффективно анализировать и исследовать данные, применяя передовые методы и техники работы с объемными данными.

Важными преимуществами Spark являются его высокая производительность, эффективность работы с большими объемами данных, оптимизации для большого объема данных, а также продуктивные средства и методы программирования.

Apache Spark предлагает ряд передовых методик работы с данными и эффективных подходов для работы с большими объемами данных. В его составе есть множество инструментов и функций для обработки, анализа и исследования данных. Использование Spark совместно с Python обеспечивает возможность использования мощных и эффективных средств для работы с большими объемами данных.

СУБД PostgreSQL

СУБД PostgreSQL (PostgreSQL) — это мощная открытая реляционная СУБД, которая обладает большими возможностями для работы с объемными данными. Эта база данных позволяет эффективно обрабатывать большие и сложные наборы данных, и является одним из ведущих решений в области работы с большими объемами данных на Python.

С использованием PostgreSQL можно проводить продуктивные исследования и анализ больших объемов данных. Благодаря передовым методам и техникам программирования на этом языке, разработчики могут изучать и обрабатывать массивы данных большого объема и выполнять сложные алгоритмы и анализ данных.

PostgreSQL предоставляет лучшие инструменты и средства для работы с большими объемами данных. Его современные подходы к обработке данных включают огромный выбор оптимальных методик и оптимизации запросов, что делает его одним из наилучших решений для работы с объемом и обработки данных.

Возможности PostgreSQL для работы с объемными данными:

- Массовая обработка данных

- Продуктивные исследование и анализ

- Методы и приемы программирования на Python

- Использование современных подходов и техник обработки данных

- Лучшие инструменты и средства работы с объемами данных

PostgreSQL также предоставляет возможность работы с крупными объемами данных. Это позволяет решать сложные задачи обработки данных и анализа наилучшим образом. СУБД PostgreSQL является отборным решением для работы с большими объемами данных на Python и обеспечивает эффективную и оптимальную обработку данных.

Использование PostgreSQL в сочетании с передовыми методами программирования и оптимизации запросов позволяет достичь наилучших результатов при работе с обширными объемами данных. Эта СУБД является одной из лучших выборов для обработки данных и предоставляет широкий набор функций и возможностей для анализа и обработки больших объемов данных на Python.